인공지능을 공부할때는 보통 코랩을 통해서 GPU를 사용한다! 하지만 집의 컴퓨터에 GPU가 장착되어 있다면 이를 활용해서 코드를 돌려볼 수도있다.

파이참에서 GPU를 사용하는 방법에 대해 다뤄보겠다

우선 아나콘다를 설치해야 한다.

https://www.anaconda.com/products/distribution

Anaconda | Anaconda Distribution

Anaconda's open-source Distribution is the easiest way to perform Python/R data science and machine learning on a single machine.

www.anaconda.com

그리고 파이썬과 파이참은 설치되어 있다고 가정해보겠다. 아나콘다는 가장 최신 버전을 설치하면 된다!

1. CUDA 설치

https://developer.nvidia.com/cuda-toolkit-archive

CUDA Toolkit Archive

Previous releases of the CUDA Toolkit, GPU Computing SDK, documentation and developer drivers can be found using the links below. Please select the release you want from the list below, and be sure to check www.nvidia.com/drivers for more recent production

developer.nvidia.com

어느버전을 설치해야하는지 간략하게 설명해 보겠다. 현재 필자가 쓴 시기에는 11.2 버전을 설치했다.

https://www.tensorflow.org/install

TensorFlow

시스템에 TensorFlow를 설치하는 방법을 알아봅니다. pip 패키지를 다운로드하거나 Docker 컨테이너에서 실행하거나 소스에서 빌드합니다. 지원되는 카드에서 GPU를 사용 설정합니다.

www.tensorflow.org

해당 링크의 좌측에 보면 GPU지원 칸이 있는데 해당 칸에서 자세한 정보를 볼 수 있다.

그후 위 부분을 봐서 TensorFlow버전과 CUDA Toolkit버전과 cuDNN 버전 세 버전을 어떤걸 설치할지 봐주면된다. 호환이 가능한 것으로 고르면 된다.

필자는

TensorFlow 2.8 CUDA Toolkit 11.2 cuDNN 8.1.1 을 선택했다.

2. cuDNN 설치

https://developer.nvidia.com/rdp/cudnn-archive

cuDNN Archive

NVIDIA cuDNN is a GPU-accelerated library of primitives for deep neural networks.

developer.nvidia.com

해당 버전들 중에서 CUDA버전에 맞는 걸 찾아서 설치하면 된다.

그러면 위 파일이 나올텐데 해당 폴더들을 복사한 후

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.2

경로에 붙여넣어주면 된다. 버전이 11.2가아니라면 해당 버전의 이름으로 폴더가 있을 것이다.

자, 이제 기본적인 설정이 끝났다.

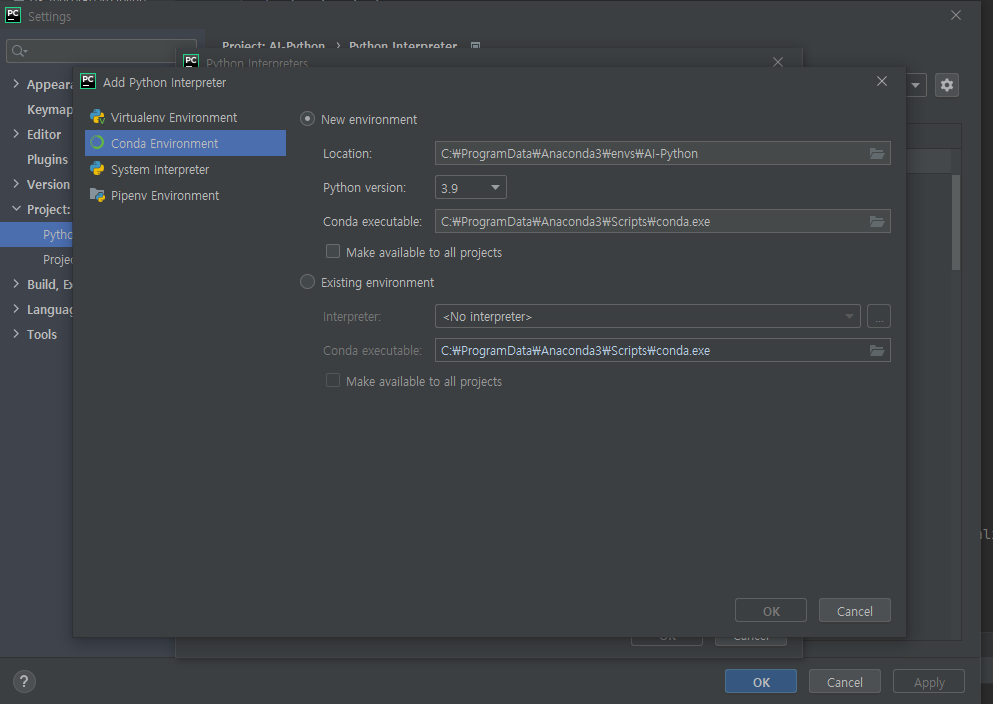

파이참에서 File - Setting - Python Interpreter로 들어간 후에 anaconda로 가상환경을 설정한다. 만약 없다면 만들어준다.

없다면 Python Interpreter안의 Show-all 을 누르고 +를 누른 후

Conda 환경으로 만들어주면된다.

이때 가상환경을 새로만들었다면 파이참을 종료했다 실행해야 정상적으로 적용이 된다.

터미널을 열어서 (가상환경 이름) 으로 가상환경상태로 인터프리터가 잘 설정되어있는지 확인을 한 후,

pip install tensorflow-gpu를통해 버전을 설치해준다.

pip install tensorflow-gpu==2.8.0 식으로 원하는 버전이 있다면 맞춰주면 된다.

from tensorflow.python.client import device_lib

print(device_lib.list_local_devices())그 후 위 코드를 실행하였을때

위와같이 GPU가 잡힌다면 정상적으로 GPU를 사용할 준비가 된 것이다.

import tensorflow as tf

print(tf.test.is_built_with_cuda())

print(tf.test.is_gpu_available())또 위코드를 실행하였을때

다음처럼 True가 두번 나와도 실행이 잘 될 준비가 된 것이다.

그후 최근 공부하고 있던 실제 학습모델을 돌려보았더니 대충 한 Epoch당 1분정도 시간이 걸리는것을 확인할 수 있었다. 코랩을 통해서 실행했을때 2분정도 걸렸었는데 더 빠르게 학습을 시킬 수 있게 되었다!

'Python > 인공지능' 카테고리의 다른 글

| 인공신경망 직접구현 (0) | 2022.06.07 |

|---|---|

| Training , Test 선택 가우시안 모델 구현하기 (0) | 2022.04.30 |

| 가우스 함수를 이용한 선형회귀 모델 직접구현 (0) | 2022.04.17 |

| 다중차원 선형모델 직접 구현 (0) | 2022.04.17 |

| 경사하강법 직접구현 (0) | 2022.04.10 |